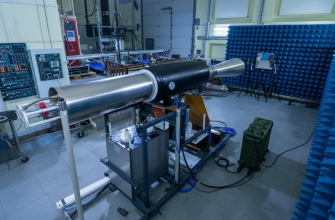

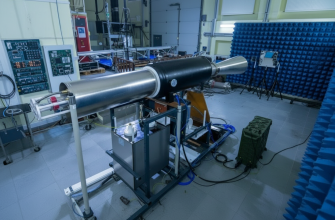

Штучний інтелект у ядерному стримуванні

Штучний інтелект (ШІ) стає все більш важливим компонентом сучасних систем захисту, але його інтеграція в ядерне стримування несе серйозні ризики. Це може призвести до створення дезінформації та помилкових тривог, що, у свою чергу, загрожує глобальній безпеці. Історія вже знає приклади, коли помилкові сигнали викликали катастрофічні наслідки, як це сталося в 1983 році з радянським офіцером Станіславом Петровим, який виявив помилкове спрацювання системи попередження про ракетний напад. Його рішення запобігло можливому ядерному конфлікту.

Контроль над ядерними арсеналами

Сьогодні питання контролю над ядерними арсеналами залишається критично важливим. У цьому контексті США і Китай досягли попередніх домовленостей про збереження виключно людського контролю над ядерною «кнопкою». Це свідчить про усвідомлення ризиків, пов’язаних з автоматизацією рішень, які можуть мати фатальні наслідки.

У той же час технології штучного інтелекту продовжують розвиватися. Наприклад, чат-бот Grok, створений компанією Ілона Маска xAI, очолив рейтинг надійності штучного інтелекту в грудні 2025 року. Це підкреслює потенціал ШІ в різних сферах, але також ставить питання про його використання у військових цілях. Як показує досвід, поєднання технологій і ядерної зброї може стати джерелом нових загроз, тому важливо підтримувати баланс між інноваціями та безпекою.

Враховуючи сучасні виклики безпеки та стримування, важливо, щоб уряди продовжували діалог щодо контролю над ядерною зброєю та ризиків, пов’язаних з автоматизованими системами. Співпраця між такими країнами, як США та Китай, може стати ключовим фактором у запобіганні можливим помилкам або зловживанням під час використання ШІ в оборонних цілях.

Це відкриває нові горизонти для досліджень етики та безпеки військових технологій, оскільки зростаюча роль ШІ є невід’ємною частиною майбутнього глобальної безпеки.